¿Por qué es necesaria la regulación de la IA?

Los reguladores de todo el mundo no han encontrado escasez de problemas por los que preocuparse con el auge de la inteligencia artificial.

¿Deberían intervenir en algoritmos que podrían sesgar o distorsionar decisiones que afectan la vida cotidiana de miles de millones? ¿Qué pasa con el riesgo de que los chatbots, como ChatGPT, aumenten la producción de información errónea en línea o conduzcan al uso indebido de grandes cantidades de datos personales? ¿Y qué deberían hacer con las advertencias de que las computadoras pronto podrían alcanzar tal nivel de inteligencia que escapen al control de sus creadores, con consecuencias potencialmente nefastas para la humanidad?

La tecnología avanza tan rápido, y los riesgos potenciales son, en algunos casos, tan poco entendidos, que todavía hay poco acuerdo sobre una agenda regulatoria.

¿Qué problemas de IA están analizando primero los reguladores?

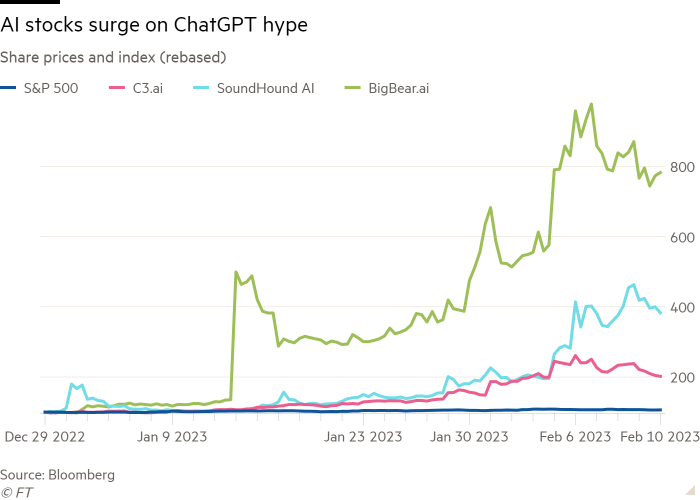

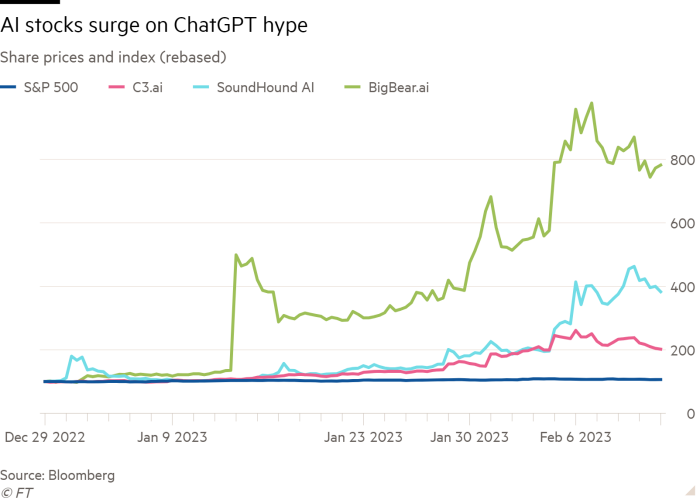

La Unión Europea estaba en camino de finalizar una Ley de IA, la primera de su tipo, que habría controlado, o incluso prohibido, los sistemas de IA supuestamente de «alto riesgo», como los que se utilizan para tomar decisiones sobre solicitudes de empleo o préstamos o tratamientos de salud. Entonces estalló la manía de ChatGPT: el gran interés público en el chatbot generativo de IA de libre acceso de OpenAI.

Los legisladores ajustaron rápidamente sus planes para incluir los llamados modelos básicos, como el modelo de lenguaje grande que se encuentra detrás de ChatGPT.

Las normas de la UE obligarían a las empresas a revelar con qué datos se han entrenado estos modelos y podrían responsabilizarse por el mal uso de la tecnología, incluso cuando no controlan las aplicaciones finales.

Sin embargo, Patrick Van Eecke, copresidente de la práctica global de cibernética, datos y privacidad del bufete de abogados Cooley, cree que Bruselas se ha movido demasiado pronto para tratar de regular una tecnología que todavía es «un objetivo en movimiento», lo que refleja un sesgo cultural hacia la regulación instintiva. “Nos gusta regular la realidad incluso antes de que se convierta en realidad”, dice, haciéndose eco de una opinión ampliamente compartida en el mundo de la IA.

Sin embargo, muchos ejecutivos tecnológicos estadounidenses tienen una explicación diferente. Lo ven como un movimiento proteccionista deliberado por parte de la UE, que impone limitaciones a un grupo de empresas principalmente estadounidenses que dominan la industria de la IA.

¿Se convertirá la regulación de IA de la UE en un modelo para el resto del mundo?

Eso es lo que sucedió con la legislación de protección de datos del bloque, y es un desarrollo potencial que preocupa a las empresas tecnológicas estadounidenses. Los partidarios de la Ley de la UE dicen que se aplicará de manera flexible para reflejar los estándares cambiantes y los avances tecnológicos. Pero los críticos dicen que la experiencia muestra que Bruselas adopta un enfoque más dogmático, y que las reglas incorporadas ahora podrían limitar la evolución de la tecnología.

Algunas empresas europeas aceptar. En una carta a la Comisión Europea en junio, 150 grandes preocupaciones europeas advirtieron que la ley podría obstaculizar la economía del bloque al impedir que las empresas utilicen libremente tecnología de IA importante.

Se debe elaborar una versión final de la ley en una negociación tripartita entre el Parlamento, la Comisión y el Consejo de los estados miembros, lo que significa que todavía existe la posibilidad de cambios.

¿No están las empresas de IA pidiendo regulación?

La industria de la IA ha aprendido de la reacción violenta contra las redes sociales que no vale la pena eludir la regulación de tecnologías que pueden tener un impacto social y político significativo.

Pero eso no significa que les guste lo que planea la UE. Sam Altman, director de OpenAI y partidario voluble de la regulación de la IA, le dijo al FT que su empresa podría tener que retirarse de la UE por completo si las reglas finales sobre IA son demasiado estrictas. El furor que provocaron sus palabras lo llevó rápidamente a dar marcha atrás, pero, tras bambalinas, las preocupaciones de Estados Unidos no se han atenuado.

La disposición de las grandes empresas tecnológicas a exigir la regulación también ha provocado sospechas de que lo ven como una forma de afianzar su control sobre el mercado de la IA. Los costos más altos y la burocracia podrían dificultar la entrada de nuevos competidores.

¿Cuál es la alternativa al enfoque de la UE?

Antes de decidir sobre nuevas leyes, muchos países están analizando de cerca cómo se aplican sus regulaciones existentes a las aplicaciones que funcionan con IA.

En los Estados Unidos, por ejemplo, la Comisión Federal de Comercio ha abierto una investigación en ChatGPT, usando sus poderes existentes. Una de sus preocupaciones es que ChatGPT está absorbiendo datos personales y, a veces, usándolos para regurgitar información falsa y dañina sobre la gente común.

A diferencia de sus homólogos europeos, los legisladores estadounidenses también se han embarcado en una amplia revisión de la IA que trata explícitamente de equilibrar los beneficios de la tecnología frente a sus daños potenciales. El líder de la mayoría del Senado de EE. UU., Chuck Schumer, ha pedido una serie de sesiones informativas y foros de expertos para los comités senatoriales más importantes, para ayudarlos a decidir qué aspectos de la IA podrían necesitar regulación.

Holly Fechner, copresidenta del grupo de la industria tecnológica del bufete de abogados Covington & Burling, ha dicho: «El bipartidismo significativo en el Congreso sobre la competencia de EE. UU. con China» hace que el enfoque de Schumer sea «un mensaje ganador, y señala que EE. UU. se está moviendo en una dirección diferente a la de Europa».

Si los gobiernos no regulan ahora, ¿no se convertirá la carrera de la IA en una peligrosa lucha contra todos?

Muchas empresas de tecnología dicen que el desarrollo de la IA debería reflejar los primeros días de Internet: los reguladores se retrasaron entonces, dejaron que floreciera la innovación y solo intervinieron más tarde, según fuera necesario.

Ya hay señales de que los nuevos estándares y acuerdos de la industria sobre las mejores prácticas en IA están comenzando a afianzarse, incluso sin una regulación explícita. En los EE. UU., por ejemplo, la industria ha estado trabajando con el Instituto Nacional de Estándares y Tecnología para codificar las mejores formas de diseñar, entrenar e implementar sistemas de IA.

También se han comprometido a revelar más sobre cómo funcionan los modelos grandes y qué datos se han utilizado para entrenarlos, aunque no está claro cómo serán las próximas empresas. Mientras tanto, no faltan propuestas de nuevos sistemas de “marcas de agua” para verificar si el contenido en línea ha sido producido por un sistema de IA generativa en lugar de una persona.

Si no se avanza en estos y otros frentes, se acelerarían en gran medida los llamados a la regulación.

Algunas personas que desarrollan IA dicen que podría destruir a la humanidad. ¿No es esa una razón para la regulación inmediata?

Nadie en la industria de la tecnología piensa que los sistemas de IA actuales representan una amenaza existencial para la humanidad y no hay acuerdo sobre cuándo, si es que alguna vez, la tecnología podría llegar a ese punto. Pero, a principios de este año, una carta abierta firmado por muchos tecnólogos pidió una moratoria de seis meses en el trabajo en los sistemas más avanzados, para dar tiempo a idear nuevos protocolos de seguridad.

Si bien los gobiernos han comenzado a considerar este tema, se necesitarían nuevos acuerdos internacionales para tratar de controlar la propagación de la peligrosa IA. Incluso entonces, tales esfuerzos pueden ser poco prácticos, dada la amplia disponibilidad de los recursos informáticos y los conjuntos de datos necesarios para entrenar los sistemas de IA.

Por ahora, las mismas empresas que están liderando la carga hacia la IA afirman que también están a la vanguardia para tratar de controlarla. OpenAI dicho en julio que estaba creando un equipo interno para comenzar a investigar formas de controlar computadoras ‘superinteligentes’, que cree que podría llegar esta década. Su solución propuesta: un nuevo sistema de IA para controlar la IA.