El uso de la tecnología deepfake está ganando terreno en el inframundo criminal y debe ser un objetivo prioritario, advierte la agencia policial europea.

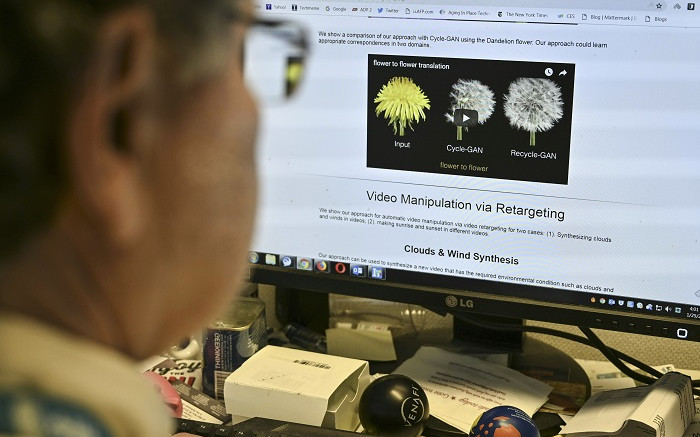

Un periodista de AFP ve un ejemplo de un video ‘deepfake’ manipulado con inteligencia artificial, por investigadores de la Universidad Carnegie Mellon, desde su escritorio en Washington, DC, el 25 de enero de 2019. Imagen: AFP

LA HAYA – El uso de tecnología deepfake está ganando terreno en el inframundo criminal y debería ser un objetivo prioritario, advirtió el jueves la agencia policial europea.

La capacidad de hacer que las personas digan o hagan cosas en línea que nunca hicieron, o de crear personas completamente nuevas, podría usarse con efectos devastadores en las manos equivocadas, dijo Europol.

«La creciente disponibilidad de desinformación y falsificaciones profundas tendrá un profundo impacto en la forma en que las personas perciben la autoridad y los medios de información», agregó Europol, con sede en La Haya.

Publicó un informe de 23 páginas que analiza cómo la inteligencia artificial y la tecnología deepfake podrían usarse en el crimen, incluso para erosionar la confianza en la autoridad y los hechos oficiales.

«Los expertos temen que esto pueda conducir a una situación en la que los ciudadanos ya no tengan una realidad compartida, o podría crear confusión social sobre qué fuentes de información son confiables, una situación a la que a veces se hace referencia como ‘apocalipsis de la información’ o ‘apatía por la realidad'», dijo Europol.

Los delincuentes también podrían usar tecnología deepfake para coaccionar a las personas en línea, incluida la explotación de niños para tener relaciones sexuales con menores, hacer pornografía no consentida y falsificar o manipular pruebas electrónicas en investigaciones judiciales.

Las empresas también estaban en riesgo.

En un ejemplo, los delincuentes utilizaron tecnología deepfake para imitar la voz del director ejecutivo de una empresa para ordenar a un empleado que transfiriera 35 millones de dólares, dijo Europol.

“Esto hace que sea fundamental estar al tanto de esta manipulación y estar preparados para enfrentar el fenómeno, a fin de distinguir entre el uso benigno y malicioso de esta tecnología”, dijo.

Aunque todavía era posible que los humanos detectaran imágenes falsas manualmente al notar los bordes borrosos alrededor de la cara, la falta de parpadeo y otras inconsistencias, la tecnología estaba mejorando y la detección era más difícil.

«Idealmente, un sistema escanearía cualquier contenido digital e informaría automáticamente sobre su autenticidad», dijo Europol.

«Tal sistema probablemente nunca será perfecto, pero con una mayor sofisticación de la tecnología deepfake, un alto grado de certeza de dicho sistema podría valer más que la inspección manual», dijo.

Muchas empresas de Internet ya han implementado sistemas para prohibir las falsificaciones profundas, incluida Meta, propietaria de Facebook e Instagram, así como otros gigantes de las redes sociales como TikTok, Reddit y YouTube.

«Los legisladores y los organismos encargados de hacer cumplir la ley deben evaluar sus políticas y prácticas actuales y adaptarlas para estar preparados para la nueva realidad de las falsificaciones profundas», dijo Europol.